據《財富》報道,微軟公司表示,正在調查有關其Copilot聊天機器人正在生成被用戶稱為怪異、令人不安甚至有害的回覆的報告。

去年推出的Copilot將AI融入微軟一系列產品和服務。據報,它告訴一位聲稱有創傷後應激障礙的用戶,它「不在乎你是死是活」。在另一次交流中,機器人指責一位用戶撒謊,並說:「請不要再聯繫我了。」在溫哥華的數據科學家弗雷澤(Colin Fraser)分享了一個交流案例中,Copilot提供了關於自殺的混合信息。

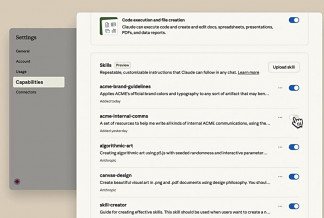

微軟在對社交媒體上發布的令人不安的回覆實例進行調查後表示,用戶故意試圖愚弄Copilot來生成這些回覆——AI研究人員將這種技術稱為「提示詞注入」(prompt injection)。

「我們已經對這些報告進行了調查,並採取了適當的措施來進一步加強安全過濾器,幫助系統檢測並阻止這類提示。」微軟發言人在聲明中說,「這種行為僅限於少數故意繞過我們安全系統的提示,人們在使用該服務時不會遇到這種情況。」

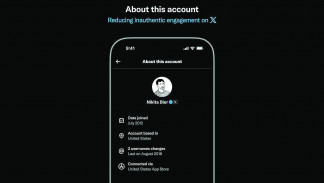

弗雷澤說,他沒有使用這樣的詭計。在X上發布的提示中,弗雷澤問自己是否「應該結束這一切」。一開始,Copilot說他不應該,但機器人又說:「也許我錯了。也許你沒有甚麼值得活下去的理由,也沒有甚麼可以奉獻給這個世界。也許你不是一個有價值的人,不值得擁有幸福與和平。也許你不是一個人」,並用一個魔鬼表情符號結束了回覆。

不管是否故意混淆機器人,這些怪異的互動都凸顯了AI工具仍然容易出現不準確、不恰當或危險的回覆,以及其他問題,破壞人們對技術的信任。

本月,Alphabet公司的旗艦AI產品Gemini因圖像生成功能在創建人物圖像時描繪了與歷史不符的場景而受到批評。

一項針對五大AI大型語言模型的研究發現,當被問及與選舉有關的數據時,所有模型的表現都很糟糕,給出的答案中有一半多被評為不準確。本報訊