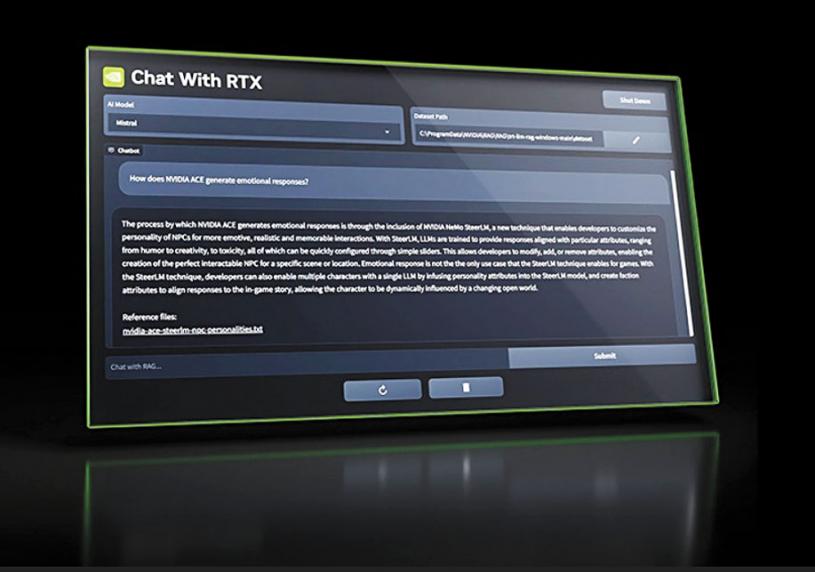

英偉達(Nvidia)發布了早期版本的Chat with RTX,這款演示版程式可以讓用戶在PC上運行個人人工智能(AI)聊天機器人。您可以向它提供YouTube視頻和自己的文檔,根據自己的數據創建摘要和獲得相關答案。這一切都可以在PC上本地運行,需要配置至少8GB VRAM顯存的RTX 30系列或40系列GPU。

The Verge的記者簡單測試了一下Chat with RTX,認為雖然這款應用還有點粗糙,但已經可以預見它將成為需要分析文檔集的人進行數據研究的重要部分。

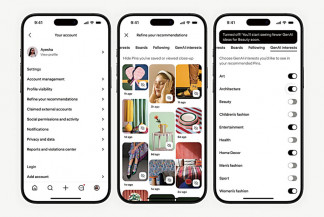

使用Chat with RTX聊天工具可以處理YouTube視頻。只需輸入URL,它就能讓您搜索提及的特定文本或總結整個視頻。它非常適合搜索視頻播客,特別方便在過去一周有關微軟新Xbox戰略轉變的傳言中,搜索播客中提及的特定內容,但記者試用時發現運行並不完美。

它在掃描讀取PDF文件和核對數據時非常有用。相比於微軟的Copilot系統在Word中不能很好地處理PDF文件,Chat with RTX系統可以毫無問題地提取出所有關鍵信息,回覆也近乎即時,完全沒有使用基於雲端的ChatGPT或Copilot聊天機器人時通常會出現的滯後現象。

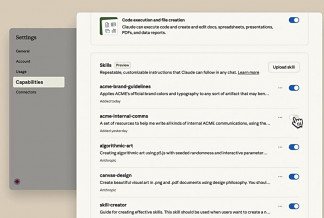

Chat with RTX本質上是在電腦上安裝一個網絡服務器和Python實例,然後利用Mistral或Llama 2模型來查詢您輸入的數據。然後,它利用RTX GPU的Tensor core來加快查詢速度。

測評使用的電腦配置是英特爾酷睿i9-14900K處理器和RTX 4090 GPU,用了大約30分鐘才將Chat with RTX安裝到電腦上。該程序大小接近40GB,Python實例佔用了大約3GB。程序運行後,您可以通過瀏覽器訪問Chat with RTX,而後台運行的命令提示符會顯示正在處理的內容和任何錯誤代碼。本報訊