蘋果研究人員在發布的最新論文中稱,已開發了一套新人工智能(AI)系統,可以理解對屏幕上實體和對話與背景的上下文內容的含糊參考,從而與語音助理有更自然的互動。

科技新聞網站VentureBeat引述3月29日刊登在論文預印本網站arXiv上的論文,這套名為「參考解析作為語言模型」(Reference Resolution As Language Modeling,簡稱ReALM)的系統利用大型語言模型,將包括理解屏幕上視覺元素等的複雜任務轉換成為純語言模型問題。相較於現有方法,ReALM可實現顯著的效能提升。

論文指出,「能夠理解上下文(包括參考)對於對話式助理而言至關重要,讓用戶可以針對屏幕上所看見的東西發問,讓語音助理切實提供服務」。

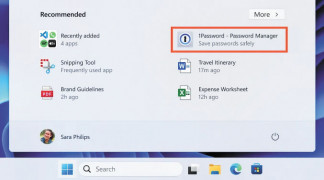

為了解決參考屏幕內容的問題,ReALM一項關鍵創新是透過分析屏幕上的實體和其位置來重建屏幕,從而生成一個捕捉視覺布局的文本表現形式,這種方法結合特別針對參考消解的微調語言模型,可以在這項任務上勝過GPT-4。研究人員寫道︰「我們展示了與既存具有類似功能的系統相比,在不同類型的參考中都取得顯著改善,最小型的模型在屏幕參考上取得超得5%的絕對增益,較大型的模型大大勝過GPT-4。」本報訊