雖然人工智能(AI)持續進步,但往往僅限單一領域,例如產生合成語音並非可以辨別人臉表情。正因如此,臉書母公司Meta研究人員正著手使AI更多才多藝,不論口頭、書面或視覺內容,都有自學能力。

訓練AI模型正確地詮釋某些內容的傳統方式,要給AI大量標籤樣本,例如一張標籤貓各部位的貓相片、發言者的對話和轉錄的詞彙。但研究人員發現,手動創建訓練下一代AI大小的數據不再可行,且難以標籤大量相片,使這種方式不再流行。

現在前景最被看好的AI系統中,部份屬於所謂自我監督系統,即可處理書本或人們互動的影片等大量未被標籤數據,然後自行對系統規則構造的理解。例如透過閱讀1,000本書,AI毋須任何人告訴它對象、題目,便能夠學習詞彙相對位置和關於文法結構的概念,即從大量例子中推算意思出來。

這直覺上較像人類學習方式,正是研究人員喜歡的原因。但那些模型仍然傾向單一模態,而所有為語音辨識而設置的半監督學習所做的工作完全不會適用於圖像分析—就是完全不一樣,此時Meta最新研究data2vec就大派用場了。

data2vec的概念是建造一種以更抽象方式學習的AI框架,意味從一開始給AI閱讀書本、掃描圖像或說出演詞,然後經過小小訓練,它就能學習任何東西。這就像由一顆種子開始,然後視乎大家給它甚麼養料,便會長出水仙、三色菫或鬱金香等。

在訓練data2vec各式數據後測試它,顯示它與同類大小的專用模型匹敵,甚至優於後者。

Meta團隊的網誌寫道︰「這種方法的核心概念是更廣義地學習︰AI應學習去做許多不同任務,包括是完全不熟悉的那些。我們亦希望data2vec將使我們更接近一個電腦只需要非常少被標籤數據以完成任務的世界。」

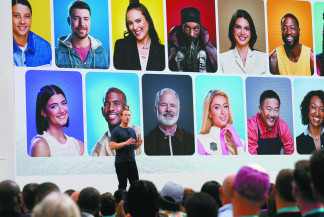

Meta執行長朱克伯格的評論寫道︰「人們透過結合視覺、聲音和文字結合去體驗世界,像這種系統總有一天能夠以我們方式去了解世界。」

由於仍屬早期研究階段,所以別指望這個傳說中的「一般AI」突然出現。但有著有一種廣義學習結構,適用於各種領域和數據類型的AI,似乎比我們今日所用零散的微智能是更佳且更簡明的解決方法。